IKLAN

GULIR UNTUK MELANJUTKAN KONTEN

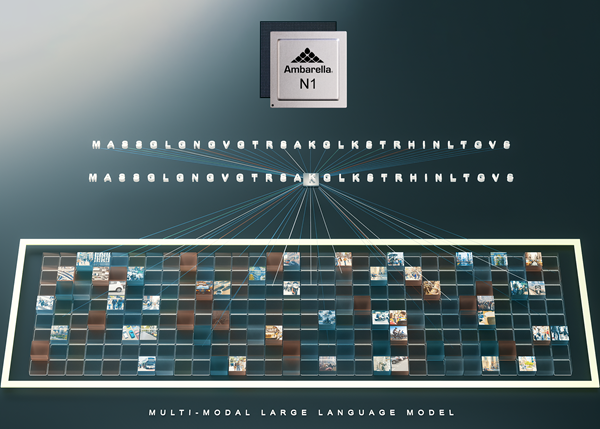

Ambarella mendemonstrasikan LLM multi-modal yang berjalan pada SoC seri N1 barunya dengan daya per inferensi yang lebih kecil dibandingkan solusi GPU terkemuka. Perusahaan ini bertujuan untuk menghadirkan AI generatif—teknologi transformatif yang pertama kali muncul di server karena diperlukannya kekuatan pemrosesan yang sangat besar—ke perangkat endpoint dan perangkat keras lokal, di seluruh aplikasi seperti analisis keamanan video, robotika, dan banyak lagi. aplikasi industri.

SoC Tunggal Mendukung Multi-Modal LLM Satu hingga 34 Miliar Parameter Dengan Konsumsi Daya Rendah, Memungkinkan AI Generatif untuk Perangkat Edge Endpoint

SoC N1 Baru Ambarella Mendukung Model Bahasa Besar Multi-Modal Dengan Parameter Hingga 34 Miliar Dengan Konsumsi Daya Rendah, Memungkinkan AI Generatif untuk Perangkat Edge Endpoint

![]()

SANTA CLARA, California, 08 Januari 2024 (Korea Bizwire) – (NASDAQ: AMBA), sebuah perusahaan semikonduktor AI edge, hari ini mengumumkan di CES bahwa mereka mendemonstrasikan model bahasa besar multi-modal (LLM) yang berjalan pada seri SoC N1 barunya dengan daya per inferensi yang lebih kecil. solusi GPU terkemuka. Ambarella bertujuan untuk menghadirkan AI generatif—teknologi transformatif yang pertama kali muncul di server karena diperlukannya kekuatan pemrosesan yang sangat besar—ke perangkat endpoint dan perangkat keras lokal, di seluruh aplikasi seperti analisis keamanan video, robotika, dan banyak lagi. aplikasi industri.

Ambarella pada awalnya akan menawarkan kemampuan pemrosesan AI generatif yang dioptimalkan pada SoC kelas menengah hingga kelas atas, mulai dari CV72 yang ada untuk kinerja pada perangkat di bawah 5W, hingga seri N1 baru untuk kinerja tingkat server di bawah 50W. Dibandingkan dengan GPU dan akselerator AI lainnya, Ambarella memberikan solusi SoC lengkap yang 3x lebih hemat daya per token yang dihasilkan, sekaligus memungkinkan penerapan produk dengan cepat dan hemat biaya.

“Jaringan AI generatif memungkinkan fungsionalitas baru di seluruh target pasar aplikasi kami yang sebelumnya tidak mungkin dilakukan,” kata Les Kohn, CTO dan salah satu pendiri Ambarella. “Semua perangkat edge akan menjadi lebih pintar, dengan seri SoC N1 kami yang memungkinkan pemrosesan LLM multimodal kelas dunia dengan daya/harga yang sangat menarik.”

“Hampir setiap aplikasi edge akan ditingkatkan oleh AI generatif dalam 18 bulan ke depan,” kata Alexander Harrowell, Principal Analyst, Advanced Computing di Omdia. “Saat memindahkan beban kerja genAI ke edge, yang terpenting adalah performa per watt dan integrasi dengan ekosistem edge lainnya, bukan hanya throughput mentah.”

Semua SoC AI Ambarella didukung oleh Platform Pengembang Cooper baru milik perusahaan. Selain itu, untuk mengurangi waktu pelanggan ke pasar, Ambarella telah mem-porting dan mengoptimalkan LLM populer, seperti Llama-2, serta model Large Language and Video Assistant (LLava) yang berjalan di N1 untuk analisis visi multi-modal untuk hingga 32 sumber kamera. Model yang telah dilatih sebelumnya dan disempurnakan ini akan tersedia untuk diunduh oleh mitra Cooper Model Garden.

Bagi banyak aplikasi dunia nyata, masukan visual adalah modalitas utama, selain bahasa, dan arsitektur SoC Ambarella sangat cocok untuk memproses video dan AI secara bersamaan dengan daya yang sangat rendah. Menyediakan SoC yang berfungsi penuh memungkinkan pemrosesan LLM multi-modal yang sangat efisien sambil tetap menjalankan semua fungsi sistem, tidak seperti akselerator AI yang berdiri sendiri.

AI Generatif akan menjadi fungsi langkah untuk pemrosesan visi komputer yang menghadirkan pemahaman konteks dan pemandangan ke berbagai perangkat, mulai dari instalasi keamanan dan robot otonom hingga aplikasi industri. Contoh LLM pada perangkat dan pemrosesan multi-modal yang dimungkinkan oleh penawaran Ambarella baru ini meliputi: pencarian kontekstual cerdas atas rekaman keamanan; robot yang dapat dikendalikan dengan perintah bahasa alami; dan berbagai pembantu AI yang dapat melakukan segalanya mulai dari pengkodean hingga menghasilkan teks dan gambar.

Sebagian besar sistem ini sangat bergantung pada kamera dan pemahaman bahasa alami, dan akan mendapatkan keuntungan dari pemrosesan AI generatif pada perangkat untuk kecepatan dan privasi, serta total biaya kepemilikan yang lebih rendah. Pemrosesan lokal yang dimungkinkan oleh solusi Ambarella juga sangat kompatibel dengan LLM khusus aplikasi, yang biasanya disesuaikan dengan skenario masing-masing; versus pendekatan server klasik yang menggunakan LLM yang lebih besar dan lebih haus daya untuk disesuaikan dengan setiap kasus penggunaan.

Berdasarkan arsitektur CV3-HD Ambarella yang kuat, awalnya dikembangkan untuk aplikasi mengemudi otonom, SoC seri N1 menggunakan kembali semua kinerja ini untuk menjalankan LLM multi-modal dengan jejak daya yang sangat rendah. Misalnya, SoC N1 menjalankan Llama2-13B dengan hingga 25 token keluaran per detik dalam mode aliran tunggal dengan daya di bawah 50W. Dikombinasikan dengan kemudahan integrasi model porting, solusi baru ini dapat dengan cepat membantu OEM menerapkan AI generatif ke dalam aplikasi apa pun yang sensitif terhadap daya, mulai dari kotak AI di lokasi hingga robot pengiriman.

Baik SoC N1 dan demonstrasi kemampuan LLM multimodalnya akan dipamerkan minggu ini di pameran Ambarella selama CES.

Tentang Ambarella

Produk Ambarella digunakan dalam berbagai aplikasi penglihatan manusia dan AI, termasuk keamanan video, sistem bantuan pengemudi tingkat lanjut (ADAS), kaca spion elektronik, perekam mengemudi, pemantauan pengemudi/kabin, mengemudi otonom, dan aplikasi robotika. Systems-on-chip (SoCs) berdaya rendah milik Ambarella menawarkan kompresi video resolusi tinggi, pemrosesan gambar dan radar yang canggih, serta pemrosesan jaringan saraf dalam yang kuat untuk memungkinkan persepsi, fusi, dan perencanaan yang cerdas. Untuk informasi lebih lanjut, silakan kunjungi www.ambarella.com.

Hubungi Ambarella

Semua nama merek, nama produk, atau merek dagang adalah milik dari pemiliknya masing-masing. Ambarella berhak mengubah penawaran produk dan layanan, spesifikasi dan harga sewaktu-waktu tanpa pemberitahuan. © 2024 Ambarella. Seluruh hak cipta.

Foto yang menyertai pengumuman ini tersedia di

Sumber: Ambarella melalui GLOBE NEWSWIRE

NewsRoom.id