Terkadang, hanya demo yang Anda perlukan untuk memahami suatu produk. Dan itulah yang terjadi pada Runware. Jika Anda mengunjungi situs web Runware, masukkan perintah dan tekan enter untuk menghasilkan gambar, Anda akan terkejut melihat betapa cepatnya Runware menghasilkan gambar untuk Anda — hanya membutuhkan waktu kurang dari satu detik.

Runware adalah pendatang baru di lanskap startup inferensi AI, atau AI generatif. Perusahaan membangun servernya sendiri dan mengoptimalkan lapisan perangkat lunak di server tersebut untuk menghilangkan kemacetan dan meningkatkan kecepatan inferensi untuk model pembuatan gambar. Startup ini telah mengumpulkan dana sebesar $3 juta dari Speedrun milik Andreessen Horowitz, Halo II milik LakeStar, dan Lunar Ventures.

IKLAN

GULIR UNTUK MELANJUTKAN KONTEN

Perusahaan tidak ingin menemukan kembali rodanya. Dia hanya ingin membuatnya berputar lebih cepat. Di balik layar, Runware memproduksi servernya sendiri dengan GPU sebanyak mungkin pada motherboard yang sama. Ia memiliki sistem pendingin yang dibuat khusus dan mengelola pusat datanya sendiri.

Saat menjalankan model AI di servernya, Runware telah mengoptimalkan lapisan orkestrasi dengan BIOS dan optimalisasi sistem operasi untuk meningkatkan waktu mulai dingin. Ia telah mengembangkan algoritmanya sendiri yang mengalokasikan beban kerja interferensi.

Demonya sendiri sangat mengesankan. Sekarang, perusahaan ingin mengambil semua pekerjaan dalam penelitian dan pengembangan dan mengubahnya menjadi bisnis.

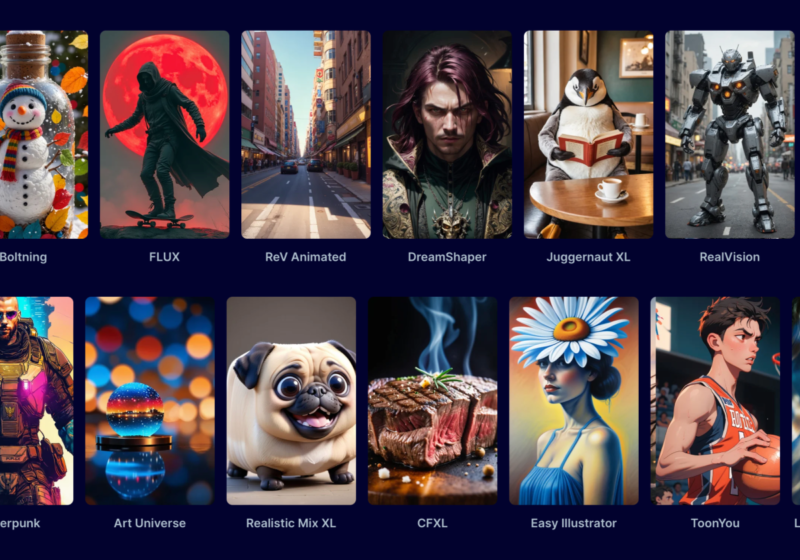

Tidak seperti banyak perusahaan hosting GPU, Runware tidak akan menyewakan GPU-nya berdasarkan waktu GPU. Sebaliknya, mereka percaya bahwa perusahaan harus didorong untuk mempercepat beban kerja. Itu sebabnya Runware menawarkan API pembuatan gambar dengan biaya tradisional per struktur panggilan API. Ini didasarkan pada model AI Fluks dan Difusi Stabil yang populer.

“Jika Anda melihat Together AI, Replication, Hugging Face – semuanya – mereka menjual komputasi berdasarkan waktu GPU,” kata salah satu pendiri dan CEO Flaviu Radulescu kepada TechCrunch. “Kalau dibandingkan dengan lamanya waktu yang kami perlukan untuk berfoto dengan mereka. Dan kemudian Anda membandingkan harganya, Anda akan melihat bahwa kami jauh lebih murah, lebih cepat.”

“Mustahil bagi mereka untuk menyamai performa ini,” tambahnya. “Khususnya pada penyedia cloud, Anda harus menjalankannya di lingkungan tervirtualisasi, sehingga menambah penundaan.”

Sementara Runware sedang mempertimbangkan keseluruhan jalur inferensi, dan mengoptimalkan perangkat keras dan perangkat lunak, perusahaan mengharapkan untuk menggunakan GPU dari beberapa vendor dalam waktu dekat. Ini merupakan upaya penting bagi beberapa startup karena Nvidia jelas merupakan pemimpin dalam bidang GPU, yang berarti harga GPU Nvidia cenderung cukup mahal.

“Saat ini kami hanya menggunakan GPU Nvidia. Tapi ini harus menjadi abstraksi dari lapisan perangkat lunak,” kata Radulescu. “Kami dapat mengganti model memori GPU dengan sangat cepat, sehingga memungkinkan kami menempatkan banyak pelanggan pada GPU yang sama.

“Jadi kami tidak seperti kompetitor kami. Mereka hanya memuat model ke dalam GPU dan kemudian GPU melakukan jenis tugas yang sangat spesifik. Dalam kasus kami, kami telah mengembangkan solusi perangkat lunak ini, yang memungkinkan kami mengganti model di memori GPU saat kami melakukan inferensi.”

Jika AMD dan vendor GPU lainnya dapat membuat lapisan kompatibilitas yang berfungsi dengan beban kerja AI pada umumnya, Runware berada pada posisi yang tepat untuk membangun cloud hybrid yang akan mengandalkan GPU dari beberapa vendor. Dan ini tentu akan membantu jika Anda ingin tetap lebih murah dibandingkan pesaing dalam inferensi AI.

Jaringan NewsRoom.id

Terkait

NewsRoom.id